สารบัญ

บทนำ

สำหรับเจ้าของเว็บไซต์และผู้เชี่ยวชาญด้าน SEO การเข้าใจวิธีที่เสิร์ชเอนจินโต้ตอบกับเว็บไซต์ของคุณมีความสำคัญอย่างยิ่ง เครื่องมือพื้นฐานอย่างหนึ่งสำหรับจัดการความสัมพันธ์นี้คือไฟล์ robots.txt ไฟล์ข้อความเล็กๆ แต่ทรงพลังนี้ทำหน้าที่เป็นผู้ดูแลระหว่างเว็บไซต์ของคุณกับบอทต่างๆ ที่ครอว์ลอินเทอร์เน็ต ไม่ว่าคุณจะต้องการเพิ่มประสิทธิภาพความสามารถในการครอว์ลของเว็บไซต์หรือป้องกันเนื้อหาบางส่วนจากการเข้าถึงที่ไม่พึงประสงค์ การรู้วิธีกำหนดค่าไฟล์ robots.txt อย่างเหมาะสมเป็นทักษะที่จำเป็นในชุดเครื่องมือดิจิทัลของคุณ

Robots.txt คืออะไร?

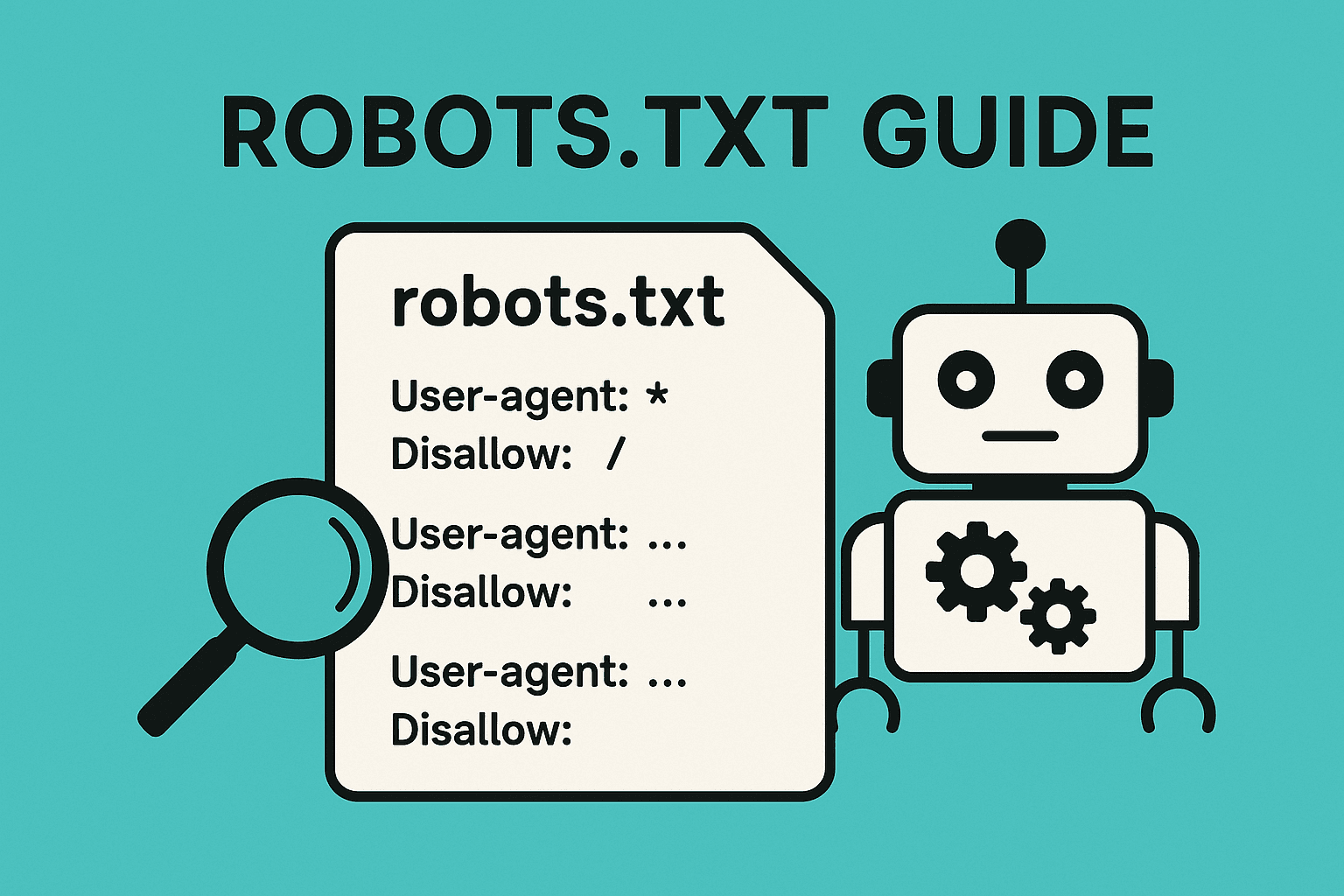

ไฟล์ robots.txt เป็นไฟล์ข้อความธรรมดาที่ให้คำแนะนำแก่เว็บครอว์เลอร์เกี่ยวกับหน้าหรือส่วนใดของเว็บไซต์ที่ควรครอว์ลและพื้นที่ใดที่ควรหลีกเลี่ยง ตั้งอยู่ในไดเรกทอรีรากของเว็บไซต์ มักเป็นไฟล์แรกที่บอทตรวจสอบก่อนที่จะครอว์ลเว็บไซต์ของคุณ

ไวยากรณ์ของ robots.txt นั้นตรงไปตรงมา แม้จะมีลักษณะที่อาจดูน่ากลัว โครงสร้างพื้นฐานใช้คำสั่งหลักสองอย่าง:

- Allow: ระบุว่าเว็บครอว์เลอร์ควรครอว์ลพาธที่ระบุ

- Disallow: บอกครอว์เลอร์ไม่ให้เข้าถึงพาธที่ระบุ

ต่อไปนี้คือตัวอย่างของไฟล์ robots.txt พื้นฐาน:

User-agent: *

Disallow: /private/

Allow: /

ในตัวอย่างนี้ “User-agent: *” หมายถึงบอททั้งหมด บอกไม่ให้พวกมันครอว์ลสิ่งใดในไดเรกทอรี “/private/” แต่อนุญาตให้ครอว์ลทุกอย่างอื่น

สิ่งสำคัญคือต้องเข้าใจว่าแม้ robots.txt จะให้คำแนะนำแก่ครอว์เลอร์ แต่ไม่ได้รับประกันว่าหน้าเว็บจะไม่ปรากฏในผลการค้นหา บอทที่ปฏิบัติตามจะเคารพคำสั่งของคุณ แต่มีข้อจำกัดสำคัญหลายประการ:

- มีผลเฉพาะกับการครอว์ล ไม่ใช่การจัดทำดัชนี

- หน้าเว็บยังคงถูกจัดทำดัชนีได้หากมีการลิงก์จากเว็บไซต์อื่น

- ไม่ใช่บอททั้งหมดปฏิบัติตามกฎ robots.txt (โดยเฉพาะที่เป็นอันตราย)

นี่คือเหตุผลที่ต้องมีมาตรการเพิ่มเติมนอกเหนือจาก robots.txt สำหรับการป้องกันเนื้อหาที่ละเอียดอ่อนอย่างแท้จริง

Robots.txt เทียบกับ Meta Robots เทียบกับ X-Robots

การเข้าใจความแตกต่างระหว่าง robots.txt และวิธีควบคุมการครอว์ล/ดัชนีอื่นๆ มีความสำคัญต่อการจัดการ SEO ที่มีประสิทธิภาพ แต่ละวิธีมีวัตถุประสงค์เฉพาะ:

Robots.txt ควบคุมสิ่งที่เสิร์ชเอนจินควรครอว์ล เป็นชุดคำสั่งทั่วทั้งเว็บไซต์ที่ป้องกันไม่ให้บอทเข้าถึง URL บางส่วน แต่ไม่จำเป็นต้องป้องกันการจัดทำดัชนี

Meta Robots คือแท็ก HTML ที่วางไว้ในส่วน <head> ของหน้าเว็บแต่ละหน้า ให้คำแนะนำเฉพาะหน้าเกี่ยวกับการจัดทำดัชนีและการติดตามลิงก์ คำสั่งที่พบบ่อยที่สุดคือ:

<meta name="robots" content="noindex, nofollow">

X-Robots-Tags ทำหน้าที่คล้ายกับแท็ก meta robots แต่ถูกนำไปใช้ผ่านส่วนหัว HTTP มีประโยชน์สำหรับไฟล์ที่ไม่ใช่ HTML เช่น PDF รูปภาพ และวิดีโอที่ไม่สามารถมีแท็กเมตาได้

ความแตกต่างหลักคือ robots.txt ป้องกันการครอว์ล ในขณะที่ meta robots และ X-robots tags ควบคุมการจัดทำดัชนี หากคุณต้องการให้เนื้อหาไม่ปรากฏในผลการค้นหาทั้งหมด คุณควรใช้คำสั่ง noindex แทนที่จะพึ่งพา robots.txt เพียงอย่างเดียว

ทำไม Robots.txt จึงสำคัญ?

การเพิ่มประสิทธิภาพงบประมาณการครอว์ล

ประโยชน์หลักอย่างหนึ่งของไฟล์ robots.txt ที่กำหนดค่าอย่างดีคือการเพิ่มประสิทธิภาพงบประมาณการครอว์ล เสิร์ชเอนจินจัดสรรทรัพยากรจำนวนหนึ่งในการครอว์ลเว็บไซต์ของคุณ และงบประมาณนี้มีจำกัด

การบล็อกหน้าที่มีคุณค่าต่ำที่ไม่จำเป็นต้องอยู่ในผลการค้นหา ช่วยให้เสิร์ชเอนจินมุ่งเน้นความพยายามไปที่เนื้อหาที่สำคัญที่สุดของคุณ หน้าที่เหมาะสำหรับการบล็อก ได้แก่:

- หน้าตะกร้าสินค้า

- พื้นที่บัญชีผู้ใช้

- หน้าผลการค้นหาภายใน

- เนื้อหาซ้ำซ้อนที่สร้างจากพารามิเตอร์ URL

- หน้าขอบคุณและจุดสิ้นสุดการทำธุรกรรมอื่นๆ

สำหรับเว็บไซต์ขนาดใหญ่ที่มีหลายพันหรือหลายล้านหน้า การจัดการงบประมาณการครอว์ลที่เหมาะสมผ่าน robots.txt สามารถปรับปรุงวิธีที่เสิร์ชเอนจินค้นพบและจัดลำดับความสำคัญของเนื้อหาของคุณได้อย่างมีนัยสำคัญ

การควบคุมการปรากฏในการค้นหา

ในขณะที่ robots.txt ไม่ได้ควบคุมการจัดทำดัชนีโดยตรง แต่ทำงานร่วมกับองค์ประกอบ SEO อื่นๆ เพื่อมีอิทธิพลต่อการปรากฏของเว็บไซต์ในผลการค้นหา:

- ไซต์แมป: การรวมการอ้างอิงไซต์แมปใน robots.txt จะช่วยให้เสิร์ชเอนจินค้นพบหน้าที่สำคัญที่สุดของคุณได้อย่างมีประสิทธิภาพ

- แท็กแคนอนิคอล: ทำงานร่วมกับ robots.txt เพื่อจัดการปัญหาเนื้อหาซ้ำซ้อน

- คำสั่ง Noindex: ใช้สำหรับหน้าที่ควรครอว์ลแต่ไม่ควรจัดทำดัชนี

ด้วยการรวมเครื่องมือเหล่านี้อย่างรอบคอบ คุณสร้างแผนที่ชัดเจนให้เสิร์ชเอนจินปฏิบัติตาม ทำให้มั่นใจว่าเนื้อหาที่มีคุณค่ามากที่สุดของคุณได้รับความสนใจที่สมควรได้รับ

การป้องกันเครื่องมือคัดลอกและบอทที่ไม่พึงประสงค์

อีกหนึ่งฟังก์ชันที่มีคุณค่าของ robots.txt คือความสามารถในการป้องกันเครื่องมือคัดลอกเนื้อหาและบอทที่ไม่พึงประสงค์ แม้ว่าบอทที่เป็นอันตรายอาจไม่สนใจคำสั่งของคุณ แต่ระบบอัตโนมัติจำนวนมากเคารพกฎ robots.txt

ในช่วงไม่กี่ปีที่ผ่านมา สิ่งนี้กลายเป็นสิ่งสำคัญโดยเฉพาะอย่างยิ่งกับการเพิ่มขึ้นของบอทฝึกอบรม AI ที่เก็บเกี่ยวเนื้อหาเว็บ เจ้าของเว็บไซต์จำนวนมากขณะนี้บล็อกครอว์เลอร์ AI โดยเฉพาะในไฟล์ robots.txt ของพวกเขาเพื่อป้องกันไม่ให้เนื้อหาของพวกเขาถูกใช้ในการฝึกโมเดลภาษาขนาดใหญ่โดยไม่ได้รับอนุญาต

การทดลองในโลกแห่งความเป็นจริงที่ดำเนินการโดยที่ปรึกษา SEO Bill Widmer แสดงให้เห็นถึงประสิทธิผลของกฎ robots.txt เมื่อครอว์เลอร์เฉพาะถูกบล็อกในไฟล์ robots.txt พวกมันเคารพกฎเหล่านั้นและไม่ได้ครอว์ลเว็บไซต์ หลังจากลบบล็อกเหล่านั้น ครอว์เลอร์สามารถเข้าถึงเนื้อหาได้สำเร็จ

วิธีการสร้างไฟล์ Robots.txt

ตัดสินใจว่าจะควบคุมอะไร

ขั้นตอนแรกในการสร้างไฟล์ robots.txt ที่มีประสิทธิภาพคือการกำหนดส่วนใดของเว็บไซต์ที่ควรหรือไม่ควรครอว์ล พิจารณาการบล็อก:

- ส่วนการดูแลระบบ

- พื้นที่บัญชีผู้ใช้

- กระบวนการตะกร้าและชำระเงิน

- หน้าขอบคุณ

- ผลการค้นหาภายใน

- เนื้อหาซ้ำซ้อนที่สร้างจากตัวกรองหรือพารามิเตอร์การเรียงลำดับ

เมื่อมีข้อสงสัย โดยทั่วไปแล้วจะดีกว่าที่จะอนุญาตให้ครอว์ลมากกว่าที่จะบล็อก ไฟล์ robots.txt ที่มีข้อจำกัดมากเกินไปอาจขัดขวางไม่ให้มีการค้นพบเนื้อหาที่สำคัญโดยไม่ได้ตั้งใจ

เป้าหมายบอทเฉพาะ

คุณสามารถสร้างกฎที่ใช้กับบอททั้งหมดหรือเป้าหมายครอว์เลอร์เฉพาะ:

- บอททั้งหมด:

User-agent: * - Google:

User-agent: Googlebot - Bing:

User-agent: Bingbot - AI crawlers:

User-agent: GPTBot(ครอว์เลอร์ของ OpenAI)

การกำหนดเป้าหมายบอทเฉพาะมีความหมายเมื่อ:

- คุณต้องการควบคุมบอทที่ก้าวร้าวซึ่งอาจทำให้เซิร์ฟเวอร์ของคุณทำงานหนักเกินไป

- คุณต้องการบล็อกครอว์เลอร์ AI ไม่ให้ใช้เนื้อหาของคุณในการฝึกอบรม

- คุณต้องใช้กฎที่แตกต่างกันสำหรับเสิร์ชเอนจินที่แตกต่างกัน

สร้างไฟล์และเพิ่มคำสั่ง

วิธีสร้างไฟล์ robots.txt:

- เปิดโปรแกรมแก้ไขข้อความธรรมดาเช่น Notepad (Windows) หรือ TextEdit (Mac)

- เขียนคำสั่งของคุณโดยใช้ไวยากรณ์ที่เหมาะสม

- บันทึกไฟล์เป็น “robots.txt”

โครงสร้างไฟล์ robots.txt พื้นฐานประกอบด้วยกลุ่มของคำสั่ง แต่ละกลุ่มเริ่มต้นด้วยการระบุ user-agent ตามด้วยกฎ allow หรือ disallow:

User-agent: Googlebot

Disallow: /clients/

Disallow: /not-for-google/

User-agent: *

Disallow: /archive/

Disallow: /support/

Sitemap: https://www.yourwebsite.com/sitemap.xml

ในตัวอย่างนี้ ครอว์เลอร์ของ Google ได้รับคำแนะนำไม่ให้ครอว์ลไดเร็กทอรี “/clients/” และ “/not-for-google/” ในขณะที่บอททั้งหมด (รวมถึง Google) ได้รับคำแนะนำให้หลีกเลี่ยงไดเร็กทอรี “/archive/” และ “/support/” คำสั่งไซต์แมปช่วยให้เสิร์ชเอนจินพบหน้าที่สำคัญที่สุดของคุณ

หากคุณไม่สะดวกที่จะเขียนไฟล์ด้วยตนเอง มีเครื่องมือสร้าง robots.txt ฟรีมากมายที่สามารถช่วยคุณสร้างไฟล์ที่มีรูปแบบถูกต้อง

อัปโหลดไปยังไดเรกทอรีรากของเว็บไซต์

เพื่อให้ไฟล์ robots.txt ของคุณทำงาน ต้องวางไว้ในไดเรกทอรีรากของโดเมนของคุณ ซึ่งหมายความว่าควรเข้าถึงไฟล์ได้ที่:

https://www.yourwebsite.com/robots.txt

วิธีอัปโหลดไฟล์:

- ใช้ตัวจัดการไฟล์เว็บโฮสติ้งของคุณ

- เชื่อมต่อผ่าน FTP และอัปโหลดไปยังไดเรกทอรีราก

- ใช้การตั้งค่า CMS หรือปลั๊กอิน (เช่น Yoast SEO สำหรับ WordPress)

ตำแหน่งมีความสำคัญ—หากไฟล์ไม่อยู่ในไดเรกทอรีราก เสิร์ชเอนจินจะไม่พบ

ยืนยันการอัปโหลดสำเร็จ

หลังจากอัปโหลด ตรวจสอบว่าไฟล์ robots.txt ของคุณทำงานอย่างถูกต้อง:

- ตรวจสอบว่าคุณสามารถเข้าถึงได้โดยไปที่ yourdomain.com/robots.txt

- ใช้เครื่องมือ SEO Thailand เพื่อตรวจสอบไฟล์ของคุณ

- ตรวจสอบข้อผิดพลาดในหน้า “การตั้งค่า” ของ Search Console ภายใต้รายงาน robots.txt

หากคุณเห็นเครื่องหมายถูกสีเขียวถัดจาก “Fetched” แสดงว่าไฟล์ของคุณทำงานอย่างถูกต้อง เครื่องหมายตกใจสีแดงบ่งชี้ถึงปัญหาที่ต้องได้รับการแก้ไข

สำหรับการตรวจสอบที่ครอบคลุมมากขึ้น คุณสามารถใช้เครื่องมือ SEO ที่ตรวจสอบไฟล์ robots.txt ของคุณและแจ้งปัญหาที่อาจเกิดขึ้นหรือข้อผิดพลาดในการจัดรูปแบบ

แนวทางปฏิบัติที่ดีสำหรับ Robots.txt

การใช้ไวลด์การ์ดอย่างระมัดระวัง

Robots.txt รองรับไวลด์การ์ดที่สามารถทำให้คำสั่งของคุณมีประสิทธิภาพมากขึ้นแต่ก็อาจเป็นอันตรายมากขึ้นหากใช้ไม่ถูกต้อง:

- เครื่องหมายดอกจัน (*) ตรงกับลำดับอักขระใดๆ

- เครื่องหมายดอลลาร์ ($) ตรงกับส่วนท้ายของ URL

ตัวอย่างเช่น:

Disallow: /search*บล็อก URL ใดๆ ที่เริ่มต้นด้วย “/search”Disallow: *.pdf$บล็อกไฟล์ PDF ทั้งหมด

ระมัดระวังกับไวลด์การ์ด เนื่องจากรูปแบบที่กว้างเกินไปอาจบล็อกเนื้อหาสำคัญโดยไม่ได้ตั้งใจ ตัวอย่างเช่น Disallow: /*?* จะบล็อก URL ทั้งหมดที่มีเครื่องหมายคำถาม ซึ่งอาจรวมถึงหน้าที่ถูกต้องที่มีพารามิเตอร์ URL

หลีกเลี่ยงการบล็อกทรัพยากรสำคัญ

ข้อผิดพลาดทั่วไปอย่างหนึ่งคือการบล็อกทรัพยากรที่เสิร์ชเอนจินต้องการเพื่อแสดงและเข้าใจหน้าเว็บของคุณอย่างถูกต้อง อย่าบล็อก:

- ไฟล์ CSS

- ไฟล์ JavaScript

- ไดเรกทอรีรูปภาพที่จำเป็นสำหรับการแสดงผลหน้า

- จุดสิ้นสุด API ที่ขับเคลื่อนฟังก์ชันเว็บไซต์

หากทรัพยากรเหล่านี้ถูกบล็อก เสิร์ชเอนจินอาจไม่เห็นเว็บไซต์ของคุณตามที่ตั้งใจไว้ ซึ่งอาจส่งผลเสียต่อการจัดอันดับของคุณ กระบวนการแสดงผลของ Google ขึ้นอยู่กับการเข้าถึงไฟล์เหล่านี้เพื่อเข้าใจเค้าโครงและฟังก์ชันการทำงานของเว็บไซต์ของคุณ

ข้อจำกัดในการป้องกันหน้าเว็บจากการค้นหา

โปรดจำไว้ว่า robots.txt ไม่ใช่เครื่องมือรักษาความปลอดภัย มันไม่ได้ป้องกันการจัดทำดัชนี—เพียงแค่การครอว์ล หากหน้าเว็บมีการลิงก์จากที่อื่นบนเว็บ เสิร์ชเอนจินยังคงรวมไว้ในดัชนีได้แม้ว่าจะไม่สามารถครอว์ลได้

สำหรับเนื้อหาที่ละเอียดอ่อนหรือ